Исследователи из ведущих американских институтов представили новую архитектуру нейронной сети Kolmogorov-Arnold Networks (KAN). Она стала альтернативой многослойным перцептронам (MLP) — принципу, разработанному еще в 1957 году.

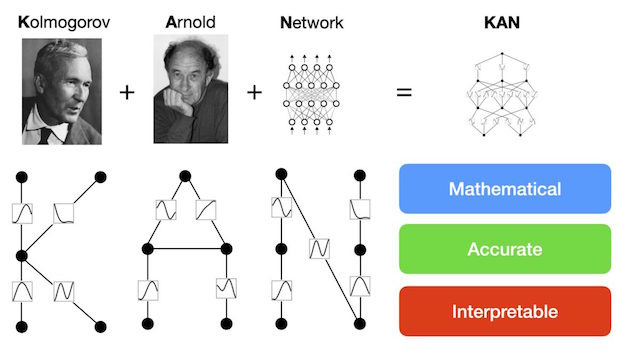

В отличие от перцептрона (MLP), представляющего упрощенную модель биологической нейронной сети, где в центр поставлена математическая модель восприятия информации мозгом, KAN основана на глубоких математических принципах. А именно — на аппроксимационной теореме советских математиков А. Н. Колмогорова и В. И. Арнольда, или теореме суперпозиции.

Исследователи отметили, что KAN, в отличие от MLP, может обрабатывать новую информацию без катастрофического забывания. Модель постоянно находится в актуальном состоянии, не полагаясь на какую-либо базу данных или переобучение.

KAN выдает ответы во много раз лучше и точнее привычных моделей, однако его обучение требует больших вычислительных мощностей. Новая архитектура может открыть возможности для дальнейшего совершенствования глубокого обучения ИИ.

По информации https://naked-science.ru/community/954608

Обозрение "Terra & Comp".

�